Sommaire

Pour ses 15 ans Online.net organisait aujourd’hui (26/09/15) une journée portes ouvertes pour découvrir la face cachée d’Internet au sein d’un de ses datacenters de Vitry-sur-Seine. Pour l’occasion, une partie de l’équipe de Sys-advisor.com s’est rendue sur place afin de vous faire vivre ou revivre cette belle journée !

Visite du #dc3 d’@online_fr sous un beau soleil pic.twitter.com/aqj9JjXXPJ

— Sys Advisor (@sysadvisor) 26 Septembre 2015

Ouvert au public de 11h à 19h, nous avons pu pénétrer au sein de ce datacenter par petits groupe de 15 environ.

Le maitre mot de cette visite : la sécurité !

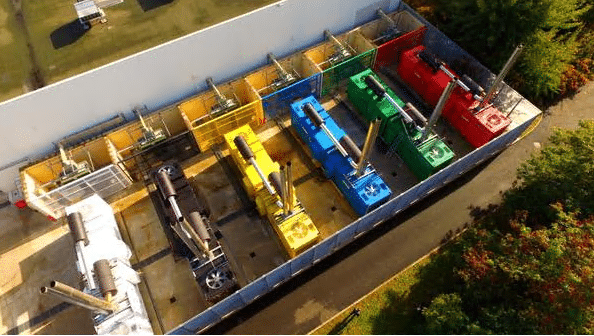

Après être passé par le détecteur de métaux, avoir rangé nos appareils photos, téléphones, bouteilles d’eau etc… nous avons pu passer le SAS de sécurité (badge + empreinte), et enfin fouler le faux plancher des presques 12.000m² du batiment. Face à nous le plan du datacenter, qui nous montre comment ce dernier est réparti. DC3 se compose de 3 grandes salles, chaque salle est réparti en plusieurs modules permettant d’avoir d’un coté les serveurs/offres online.net, d’un autre les serveurs des clients (infogérants, gros clients etc…). A l’heure ou nous écrivons ces lignes, la 1ere salle est pleine, la seconde l’est à 70% enfin la 3ème est en phase d’être terminée. En prévision de la mise en prod prochaine de cette dernière salle, de nouveaux groupes électrogènes sont arrivés cette semaine, ce qui portera la capacité totale du site à 15MW, assez pour assurer une haute dispo des 3 salles !

#dc3 Photos aériennes de l’espace groupes électrogènes et transformateurs, ça pète ! pic.twitter.com/hjeuilIexQ — Online.net – Arnaud (@online_fr) 25 Septembre 2015

Bref, revenons à la visite, nous n’en sommes qu’au début ! Nous venons donc de passer le sas de sécurité, et sommes dans les couloirs qui desservent bureaux, salles serveurs, locaux techniques etc…

Le NOC

Nous entrons alors au coeur du datacenter, le NOC, « le cerveau » du datacenter. Ici se relaye une équipe de 4 personnes maximum, qui a la vision sur tout le datacenter (entrées, sorties, stock, tickets clients), toutes les caméras du site ainsi que des informations techniques (température, puissance elecrique etc…) sont directement projetées sur le mur de la salle.

C’est depuis ce poste que les chefs d’équipe reçoivent et dispatchent les interventions vers chaque technicien en mouvement sur le datacenter ; ces derniers se déplacent généralement en trottinette, afin d’optimiser la prise en compte d’un incident (délai de prise en charge garanti : 15min).

Nous continuons notre escapade et passons devant le bureau de la direction, vide … puis devant une belle salle de réunion avec un mur végétal ! C’est d’ailleurs à ce moment la que l’on apprend que pour des raisons de sécurité, les portes ne peuvent pas rester ouverte trop longtemps sous peine de déclencher une alarme ! (ouille les oreilles!)

La salle opérateurs

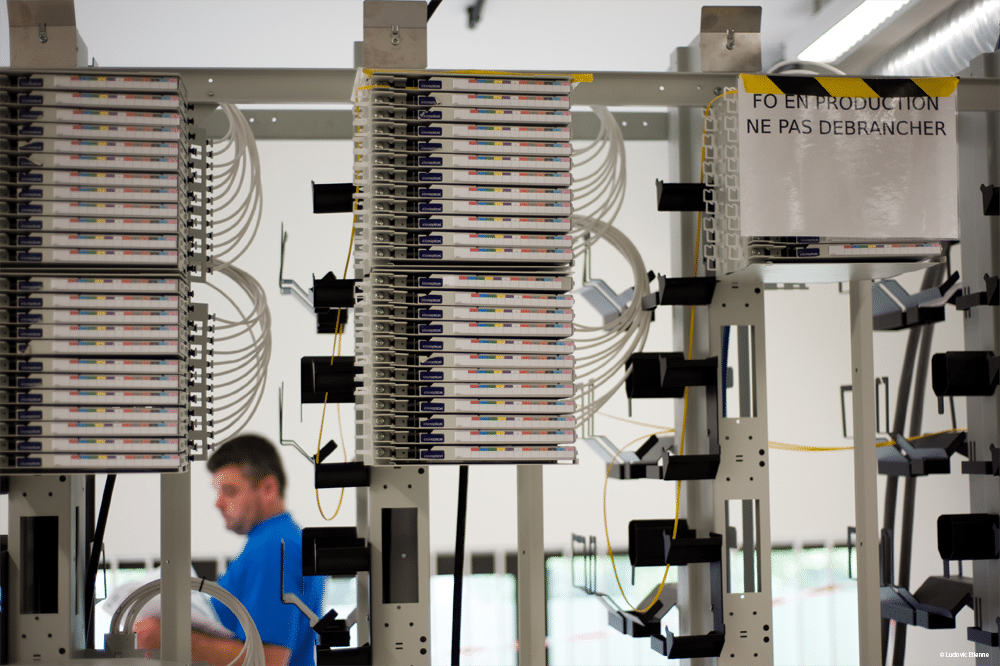

Direction l’une des deux salles opérateurs. Les salles opérateurs permettent aux gros fournisseurs d’accès (SFR, Orange etc…) de faire entrer leur réseaux dans le datacenter, et de le diffuser sur le site.

C’est dans cette salle opérateur que l’on retrouve le cœur de métier d’Online. Chaque opérateur dispose d’une/plusieurs arrivées sur ce que l’on appelle des « tetes de module optique » qui permettent ensuite de se connecter jusqu’à leur baie puis afin d’avoir accès aux serveurs.

La salle serveurs

Devant l’entrée de chaque salle serveur se trouve un écran répertoriant toutes les informations liées à la température, aux armoires électrique, armoires de climatisation (température de soufflage, température de reprise). Les données semblent être actualisées toutes les minutes et permettent d’avoir un etat général de la salle.

Comme expliqué au début de cet article, chaque salle est découpée en plusieurs modules et en fonctions des offres proposées par Online. Cela permet des interventions plus simple et surtout plus rapide.

Exemple d’une salle serveurs vide découpée en plusieurs modules

Exemple d’une salle serveurs vide découpée en plusieurs modules

Le faux plancher a été conçu à 1m10 de haut ! Ce qui laisse la place pour la climatisation et l’électricité (placée à 90cm du sol) mais également assez de marge pour une éventuelle inondation. Quant à l’arrivée des fibres elles passent par le haut des baies par des chemins de câbles suspendus.

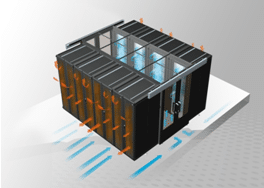

Toutes les salles disposent de baies étanches à l’air et refroidies par ce que l’on appel « un couloir froid » qui propulse l’air par le dessous (faux plancher). L’utilisation de couloirs froids permet d’optimiser le refroidissement du matériel et de baisser les coups de climatisation puisqu’il y a une surface plus petite à refroidir.

Principe de fonctionnement d’un couloir froid

Principe de fonctionnement d’un couloir froid

Tous les serveurs sont mono-alimenté. Cependant chaque baie dispose d’un STS. Un STS est un module qui permet d’avoir 2 entrées électrique (sources) et une ou plusieurs sorties pour alimenter des serveurs ou des multiprises. Cela permet d’avoir une redondance tout en ayant qu’un seul port d’alimentation par serveur. Ce système est généralement utilisé pour les switchs.

Gestion des incendies par brumisation

Online a mis en place un système d’extinction d’incendie par brouillard d’eau. L’eau est envoyé a une pression de 140 bars, par des buses situées en hauteur dès lors que celles-ci détectent une température supérieur à 57°c. Seules les buses dont la température a été atteinte diffuseront le brouillard.

Le déclenchement d’une pré-alarme est réalisé en amont par le biais « d’aspirateurs » qui analysent l’air de la salle en continu mais également par des détecteurs optiques situés au bout de chaque tuyaux, qui analysent l’opacité de l’air.

Ici donc, pas de gaz FM200 ou d’azote, cela coûterais beaucoup trop cher pour des salles de 1600m². De plus, le temps de rechargement/remplacement des bouteilles est d’environ 2 à 3 jours, ce qui augmenterai le risque car plus de sécurité incendie.

L’autre avantage de cette solution c’est que les serveurs peuvent continuer à tourner pendant environ 25 à 30 minutes puisque grâce au brouillard d’eau l’alimentation n’est pas coupée.

Ci-dessous, un test grandeur nature du système de brumisation réalisé par Iliad, dans son datacenter.

Tableau General Basse Tension (TGBT)

Le datacenter est constitué de 4 salles comme celle-ci. C’est dans cette salle que le courant délivré par EDF (200.000Volt) est converti en 410volt, qu’il passe dans les onduleurs et qu’il est transformer plusieurs fois en courant alternatif/continu.

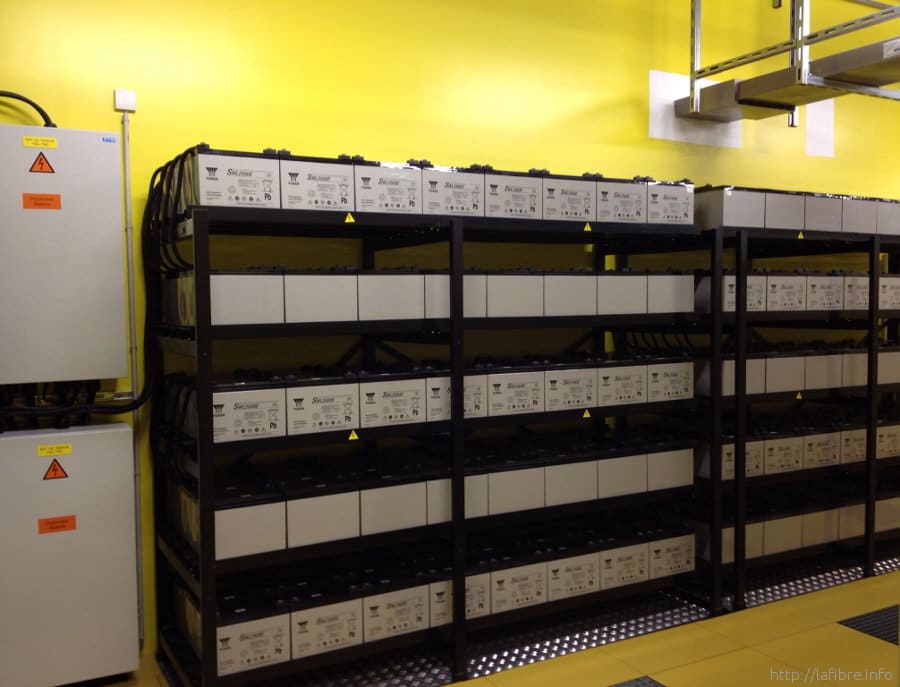

En cas de défaillance électrique, les groupes électrogènes présents à l’extérieur du bâtiment démarrent en 30 secondes. Durant cette fenêtre de 30 secondes, une série de batterie présente dans le local TGBT prend le relais afin d’assurer une continuité de service. La plupart des coupures électriques ne dépassent pas 10 secondes, ce qui permet donc de ne démarrer les groupes qu’en cas de force majeure.

Exemple de batteries

Les groupes électrogènes

On termine la visite en extérieur, par les groupes électrogènes. Cette semaine ont été livré 6 nouveaux groupes permettant de porter la puissance à 15MW.

Ces gros bébés sont alimentés par 2 cuves de 40.000 litres de fioul chacune + une nourrice de 500 litres chacune. Ils démarrent en moins de 15 secondes et ont une autonomie d’environ 48 à 50 heures. Chaque groupe est constitué de 2 démarreurs, si le premier démarreur ne fonctionne pas il passe au second, et si le second ne fonctionne pas il regarde quel groupe électrogène est disponible et essaye sur celui-ci jusqu’à temps qu’un groupe démarre.

Conclusion

Une équipe « réduite » de 25 personnes incluant techniciens et responsables d’équipe, gère ces quelques 90.000 serveurs en 24/7, afin d’assurer une réactivité et une disponibilité proche de 100%.

Vous trouverez ci-dessous le résumé de la visite en vidéo, reprenant pour la majorité des cas, les infos évoqués ci-dessus.

Nous remercions toute l’équipe d’Online.net pour son accueil, sa disponibilité et son organisation. Cela permet de faire découvrir au grand public la face cachée d’internet, qui n’est trop souvent que virtuel pour la majorité des utilisateurs.

L’équipe Sys-advisor.com

![[TUTO] – Installer Pokemon Go sur iPhone/iOS [TUTO] - Installer Pokemon Go sur iPhone/iOS](https://sys-advisor.com/wp-content/uploads/2016/07/Splash_Pokemon_GO_logo.png)

![[TUTO] – Synology : Comment sauvegarder vos données Office 365 avec Synology](https://sys-advisor.com/wp-content/uploads/2017/11/splash_synology_3-1-100x70.jpg)

![[TUTO] – Windows 10 : Comment générer une CSR avec cygwin et openssl](https://sys-advisor.com/wp-content/uploads/2019/09/splash_windows10-100x70.jpg)

![[TUTO] – Windows 2008 : Comment désactiver l’autoconfiguration IPv4](https://sys-advisor.com/wp-content/uploads/2019/08/splash_windows_server-100x70.jpg)

![[TUTO] – Recalbox : Comment ajouter de nouvelles ROMS à votre Recalbox](https://sys-advisor.com/wp-content/uploads/2017/11/splash_recalbox-100x70.png)

![[TUTO] – Windows 10 : Comment gérer, activer ou désactiver l’indexation](https://sys-advisor.com/wp-content/uploads/2018/01/splash_windows10-100x70.jpg)